國立研究開發法人理化學研究所(簡稱「理研」)資訊統合本部守護者機器人項目(GRP)人機協調研究團隊的古川淳一朗(研究當時)研究員,以及森本淳客座主管研究員的研究團隊,開發出了一種AI驅動型控制方法,可根據穿戴者的身體運動資訊和第一人稱視角影像,生成穿戴式運動助力機器人的控制指令(信號)。作為利用機器人的日常動作支援技術,該成果有望為日益加劇的老齡化社會做出貢獻。相關研究成果已發表在《npj Robotics》上。

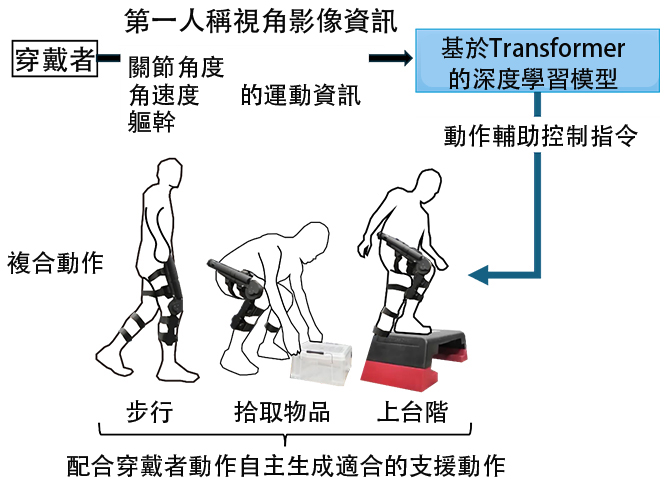

圖1:基於AI驅動控制的助力機器人示意圖(供圖:理研)

研究團隊探討了將攝像機捕捉穿戴者週遭環境的第一人稱視角影像作為有用資訊來源的可能性,並提出了一種控制方法,使穿戴式運動助力機器人能夠準確估計穿戴者的意圖並進行支援。

這種方法以第一人稱視角拍攝的影像和由穿戴者的關節角度、角速度、軀幹旋轉運動資訊構成的身體運動資訊作為輸入。基於這些資訊,提出了一種基於Transformer架構的深度學習模型,用於輸出穿戴式運動助力機器人的控制指令,從而生成支援動作的方法。該方法通過學習穿戴者週遭環境與身體運動模式之間的相互關係,預測穿戴者的動作,實現自適應的輔助動作。其獨特之處在於引入了第一人稱視角影像,並且在無需使用棘手的生物信號的情況下控制了助力機器人。

圖2:採用新方法的機器人系統動作支援示意圖(供圖:理研)

以第一人稱視角影像和由穿戴者的關節角度、角速度、軀幹旋轉運動資訊構成的身體運動資訊作為輸入;基於Transformer的深度學習模型生成適合動作及週遭環境的動作輔助控制指令。實驗中驗證了由步行、拾取物品、上台階等構成的複合動作。

該方法的驗證通過兩個階段的實驗進行。

實驗中使用了與國際電氣通信基礎技術研究所(ATR)共同自主研發的穿戴式運動助力機器人。該機器人通過將氣壓人工肌肉致動器內置於碳樹脂框架中,實現了超輕量化,即使在無控制狀態下,佩戴者也能靈活運動。

第一階段,讓該穿戴式運動輔助機器人的穿戴者在無輔助動作控制的狀態下,按任意順序執行「步行」、「下蹲拾取地面物體」、「上台階」等複合動作。同時拍攝此時的第一人稱視角影像並測量關節角度、角速度、軀幹旋轉運動等身體運動資訊,並讓佩戴者通過手持按鈕,在動作過程中隨定時記號注其感覺到「需要輔助」或「不需要輔助」的區間。利用由此獲得的第一人稱視角影像、佩戴者的身體運動資訊以及帶有輔助需求標籤的數據集,對新提出的方法模型進行了訓練。

第二階段,將基於第一階段訓練好的模型而實現的新方法,整合到穿戴式運動輔助機器人中,構建了機器人系統。在使用該機器人系統進行即時控制的動作輔助實驗中,讓運動輔助機器人的穿戴者按任意順序執行相同的複合動作,以驗證其方法的有效性。動作輔助的有效性通過測量實驗參與者的肌肉活動和心率進行評估,而機器人輔助動作生成的精度則通過配備基於肌電圖的傳統方法進行比較來進行驗證。

結果表明,與未穿戴機器人的情況相比,使用配備新方法的穿戴式運動輔助機器人進行輔助時,穿戴者的肌肉活動量有所減少。此外,將該機器人系統應用於新的實驗參與者時,同樣確認了肌肉活動量的減少。這表明該控制模型可能具備較高的泛化能力,能夠高精度地適用於不同用戶。

另一方面,在機器人輔助動作生成方面,也確認達到了與基於肌電圖的傳統方法同等或更高的精度。

儘管肌電圖等生物信號傳感器的可穿戴化日益進步,但其處理需要高度的專業性,並非易事。本次提出的方法,無需依賴生物信號傳感器也能實現高精度輔助動作控制。由此,有望推動穿戴式運動輔助機器人自主控制技術的進步。

原文:《科學新聞》

翻譯:JST客觀日本編輯部

【論文資訊】

期刊:npj Robotics

標題:Transformer-based multitask assist control from first-person view image and user's kinematic information for exoskeleton robots

DOI:10.1038/s44182-025-00033-4