日本東北大學林部充宏教授等人開發出一種能讓機器人基於觸覺資訊自主決定行動的人工智慧(AI)。這種機器人能夠通過觸碰黏扣帶表面來識別正反面,並能完成纜線捆紮的作業。目前主流AI以圖像資訊為基礎,而觸覺資訊的引入有望實現更高級別的作業。

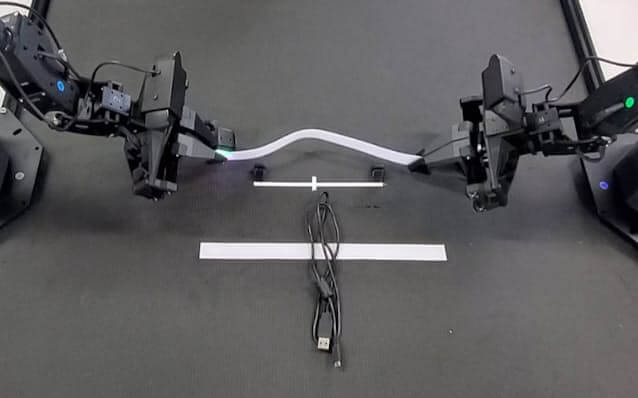

機器人通過手臂前端的觸覺傳感器識別黏扣帶的正反面(供圖:東北大學林部充宏教授)

此次開發的AI,其工作原理是基於安裝在機器人手臂前端的觸覺傳感器所獲取的資訊以及攝像頭所捕捉的圖像,由AI生成機械臂的動作步驟並執行作業。研究團隊通過遠程操作對機器人進行了1小時左右的訓練,再讓AI學習這些作業數據。結果顯示,機器人能以90%以上的精度將隨機擺放的黏扣帶配對粘貼。

對於正反面顏色相同的黏扣帶,僅通過攝像頭捕捉的圖像很難識別出粘貼面。研究團隊通過結合圖像資訊中所沒有的觸覺資訊,實現了機器人正確粘貼黏扣帶的作業。

人類可以一邊單手操作手機,一邊不用看就用另一隻手拿起放在桌邊的杯子喝水。這種同時執行多項作業的「多任務處理」能力對現有機器人來說難度很大,要實現這一功能,需要有像大腦一樣綜合處理視覺、觸覺、聽覺等多種資訊的機制。

相關研究成果的論文已發表在國際學術期刊《IEEE Robotics and Automation Letters》上。研究團隊計劃今後進一步推進結合了聲音資訊的機器人AI的開發。

原文:《日本經濟新聞》、2025/7/29

翻譯:JST客觀日本編輯部

【論文資訊】

期刊:IEEE Robotics and Automation Letters

論文:TactileAloha: Learning Bimanual Manipulation with Tactile Sensing

DOI:10.1109/LRA.2025.3585396