能否擷取聲音和周圍的情況,並自發地採取照顧周全的行為?這一直是被認為正快速演化的機器人尚不如人類的領域之一。日本理化學研究所(以下簡稱「理研」)正致力於利用人工智慧(AI)的核心技術深度學習來幫助機器人獲得這種能力。希望讓機器人能根據過去的資訊做出判斷,實現接近人類的互動。2050年有望實現善解人意的機器人。

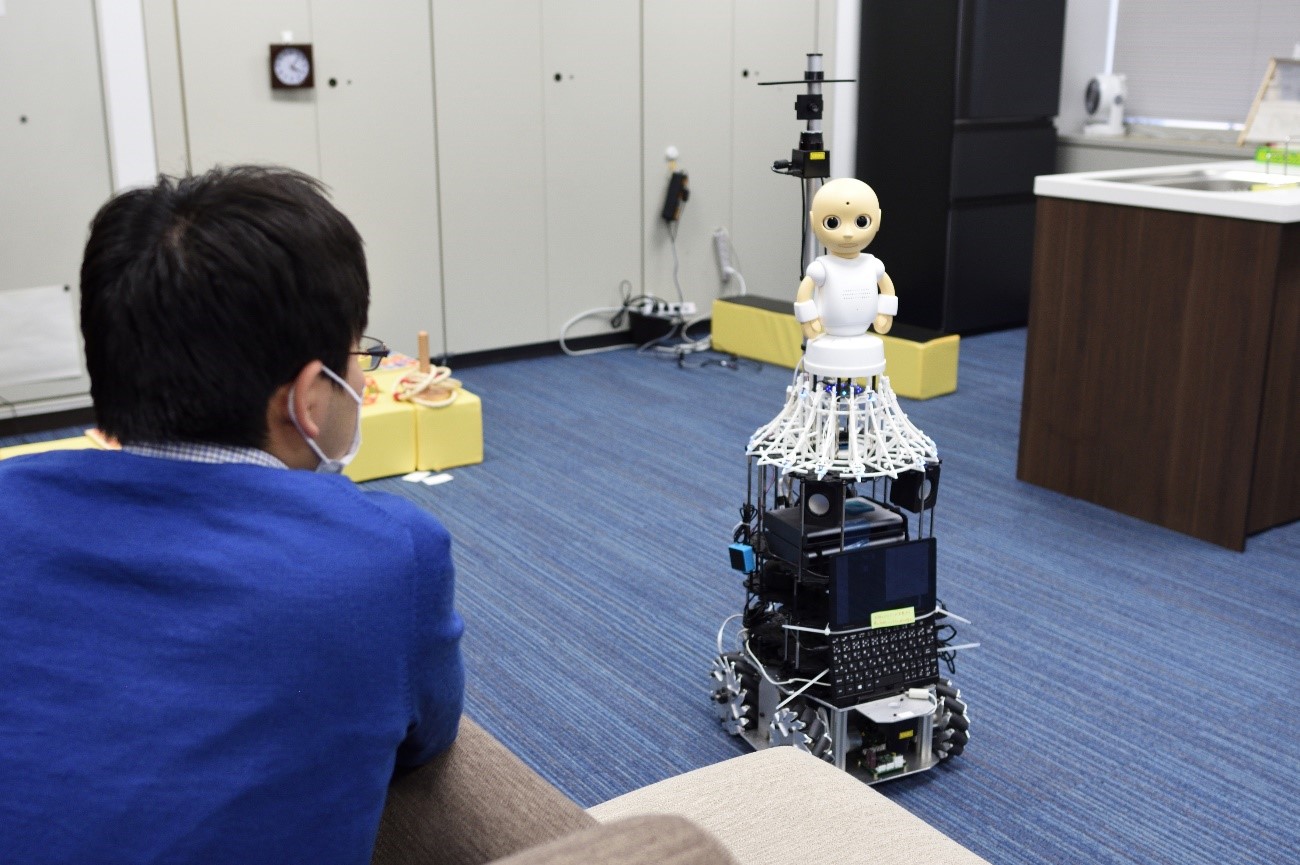

「嘮叨君,去門口看看」,當聽到學生發出的指令後,「嘮叨君」機器人邊回答「真拿你沒辦法啊」,邊朝著房間的門口方向移動,移動過程中還會介紹周圍的情況,比如「這裏有一個杯子、「我覺得房間裏明亮又舒適噢」。這就是理研監護機器人項目(Guardian Robot Project)吉野幸一郎組長等人開發的互動機器人。

可以跟人對話的機器人「嘮叨君」(圖片由理研提供)

理研的「嘮叨君」機器人擁有相當於人類的眼睛、耳朵和皮膚的功能。它配備了攝像頭、麥克風以及檢測輝度和溫度的感測器等,並使用一種稱之為「多模態整合」技術來收集外部資訊,並結合起來。其特點是能識別眼前的人和物體等,並能做出回應。

以往的家用機器人和語音助手等APP是根據現有的模式和規則來回答問題。吉野組長介紹說:「以往的家用機器人和語音助手只能根據對方講話的内容來判斷如何回答,而無法考慮周圍的情況。」

理研研究的是讓如何機器人將過去的資訊作為判斷材料來回答。人們不僅根據他們在現場看到和聽到的資訊做出判斷,還會根據過去的記憶等做出判斷。理研按照人類的思考模式,讓機器人也考慮過去的事情和學到的知識等。例如,聽到「杯子在哪裏」的問題後,會根據過去的圖像資訊,結合周圍情況回答「應該在桌子上」或者「之前在廚房裏看到過」。

人經常問一些模棱兩可的問題或者說一些模棱兩可的話,研究人員正在開發能對此作出妥善回應的AI。通過讓其配對學習諸如「風景太美了」或「肚子餓了」等設想介紹觀光資訊的約3萬條發言和回答,已經能以約90%的精度對問題做出妥善回應。如果將這種AI應用於機器人的話,它就能夠執行貼心的行動,例如,當人口渴時,機器人就會提議說「我去幫你拿杯水吧」。

機器人能說出的内容和行動的選項越多,就越能告訴人們它為何採取這樣的行動。這樣,人也能理解機器人從周圍的情況和聲音中擷取到了什麼資訊,以及是如何應對的。

目前的長期課題是讓機器人自發地決定應該採取什麼樣的行動。比如房間裏同時存在智慧型手機快要從桌子上掉下來和脫下的襪子被亂丟在地板上的情況時,它應該首先處理哪種情況?如果機器人知道智慧型手機掉下來可能會摔碎屏幕的話,它就能先移動到桌子的位置。

目前的機器人很難大量掌握這種「常識」。吉野組長預測說:「大約到了2050年前後,機器人才能作到像管家一樣可以自主地解決問題。」

判斷和行動的說明獲得信賴

| 語音對話系統研究的歷史與前景 | |

| 1960年代 | 開始推進人工智慧起源的研究 |

| 1990~2010年 | 大力推進圖像解析和話音辨識等核心技術的開發 |

| 2010年代 | “Siri”等語音助手功能普及 |

| 2020年 | 通過深度學習,多項核心技術取得發展 |

| 2025年 | 機器人在無人的空間裏工作,倉庫貨物裝卸等實現全自動化 |

| 2030年 | 與人合作的機器人開始普及 |

| 2050年 | 開發出像管家一樣的機器人 |

2010年代,AI通過自動提取學習數據特徵的深度學習取得了飛躍發展。開發作為能呈現AI判斷理由的「可解釋AI(XAI)」,這一點不僅對機器人與人的溝通很重要,也是讓人信賴AI系統的關鍵點。

AI越複雜,其過程就越容易黑盒化,說明理由就成了一個難度大無法推進的問題。尤其是醫療現場和金融機構都負有解釋責任,需要明確出示判斷的依據。因此亟需開發會說明理由的AI。

機器人也一樣,理研的吉野組長表示,使其具備解釋能力「有助於實現能與人類自然交談和共生的機器人」。

美國國防部高級研究計劃局(DARPA)正在推進有關可解釋性的研究,加利福尼亞大學等也加入了其中。日本方面,NTT東日本和日立製作所於2021年9月啟動了利用XAI和趨勢數據建立AI預測模型以最適化業務活動的驗證實驗。

隨著新技術不斷湧現,可靠性問題變得非常重要。雖然AI技術的發展變得難以預測和理解,但必須努力設法得到所有人的身份鑑定。

日文:高崎文、《日經產業新聞》,2022/01/21

中文:JST客觀日本編輯部