東京工業大學的小池英樹教授等人與美國卡内基梅隆大學等合作,開發了可以利用胸部佩戴的1臺相機的影像來推測客戶姿勢的技術。人工智慧(AI)通過識別廣角魚眼相機拍攝的影像中的四肢和頭部等來推測客戶的姿勢。以前需要使用多個相機,或者穿著特殊的衣服拍攝,導入費用也比較高。預計新技術將用於運動和醫療現場等領域。計劃2~3年後實現實用化。

推測人類運動過程中的姿勢的技術稱為「動作捕捉」。主要用於包含實際人體動作的動畫製作現場等。在運動領域,有望用來分析比賽中的運動員的姿勢,在醫療領域則有望用來掌握復健訓練患者的狀態。

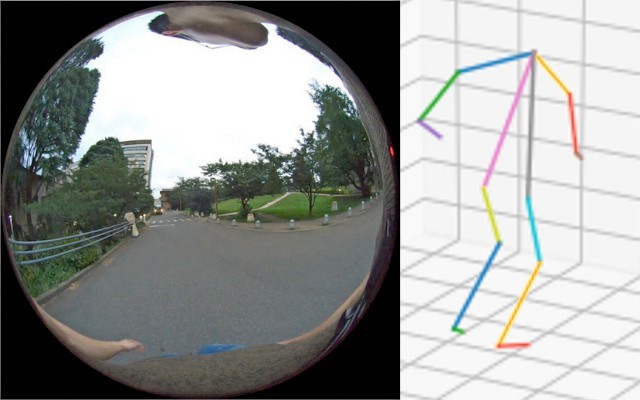

新方法是在客戶的胸部佩戴視角為280度的魚眼相機進行拍攝。影像中顯示四肢和頭部,AI會學習這些影像與姿勢之間的關係。輸入影像後即可輸出客戶的姿勢。包括軟體在内,預計導入費用隻需幾十萬日元。

在胸部佩戴魚眼相機拍攝動作=圖片由東京工業大學的小池教授提供

AI的學習需要大量訓練數據,這些數據要顯示魚眼相機拍攝的影像與姿勢之間的關係。利用由68萬張魚眼相機圖像構成的影像(使用三維CG(計算機圖形)製作)和姿勢數據進行學習。

完成學習後,研究團隊向AI輸入由實際佩戴魚眼相機拍攝的1萬6千張圖像構成的影像,試著推測了姿勢。以利用常規方法、即使用多臺相機拍攝獲得的姿勢為準確數據,調查了新方法與之相比存在多大的誤差。

各關節的誤差平均約為8.5釐米。輸入未學習的CG數據時,整體的平均誤差約為4.4釐米。小池教授說:「通過增加學習數據或變更為實際數據,精度應該能進一步提高」。

AI會識別相機中拍攝的四肢和頭部等(左)推測姿勢(右)=圖片由東京工業大學的小池教授提供

新開發的AI還可以將魚眼相機的影像轉換成人類平時看到的第一人稱視角的影像。AI會推測客戶頭部的姿勢,僅從魚眼影像中檢測客戶所看的部分。然後合成第一人稱視角的影像。小池教授說:「在運動等場景,所看的物體和方向大多很重要」。

以前為高精度推測運動過程中的姿勢,一般是在房間的天花板和牆壁上固定多臺高性能相機,然後穿著帶有標記的衣服進行拍攝。導入費用高達數百萬日元。也可以利用遊戲用途等普及的紅外感測器,但運動範圍受限,很難在寬闊的空間移動使用。

日文:張耀宇、《日經產業新聞》、2020年11月11日

中文:JST客觀日本編輯部